El uso de GPT4 por los pacientes plantea una serie de oportunidades y retos legales en relación con la responsabilidad patrimonial sanitaria de la administración. Por un lado, GPT4 puede ser una herramienta útil para facilitar el acceso a la información médica, el diagnóstico, el tratamiento y el seguimiento de las enfermedades, así como para mejorar la comunicación entre los pacientes y los profesionales sanitarios. Por ejemplo, un paciente con una enfermedad crónica podría usar GPT4 para consultar sus dudas, recibir consejos personalizados, monitorizar sus síntomas y alertar a su médico en caso de complicaciones. Esto podría mejorar su calidad de vida y su adherencia al tratamiento.

Por otro lado, GPT4 también puede generar riesgos de errores, malas prácticas, violación de la confidencialidad, daños a la salud o vulneración de los derechos de los pacientes. Por ejemplo, un paciente con una enfermedad grave podría usar GPT4 para obtener un diagnóstico y este resulta ser erróneo o incompleto. Esto podría provocar un retraso en el tratamiento adecuado, un empeoramiento de su estado o incluso su muerte.

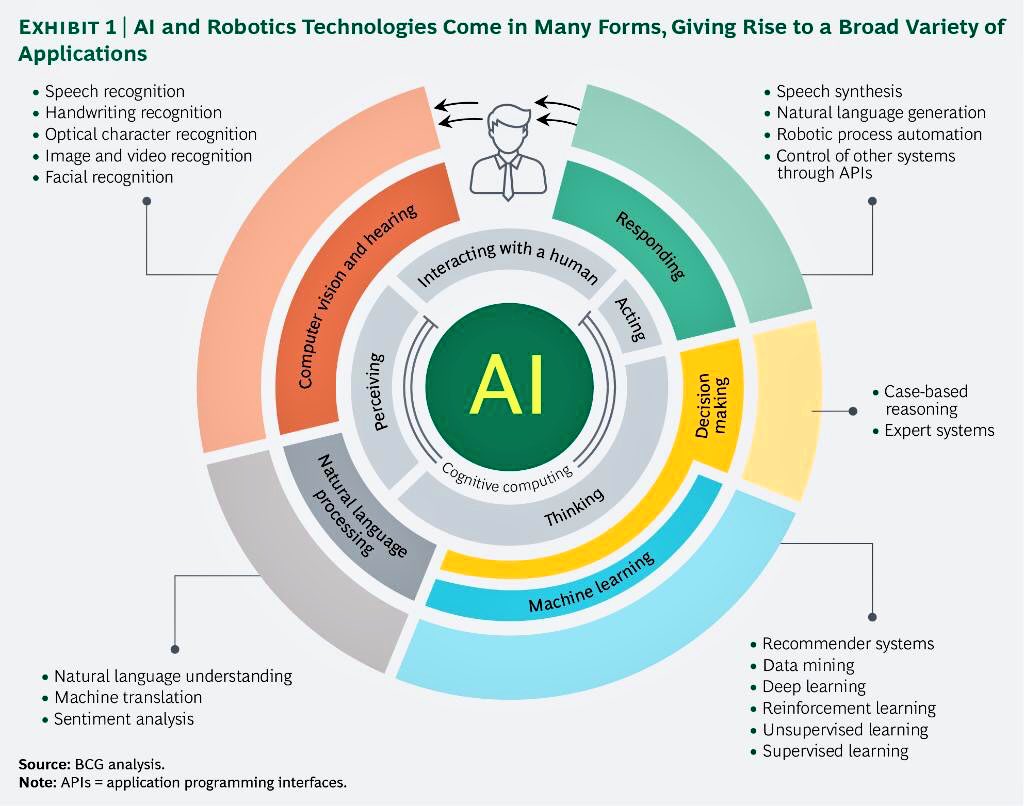

En este contexto, es necesario analizar el marco jurídico aplicable al uso de GPT4 por los pacientes, tanto desde el punto de vista de la regulación de la inteligencia artificial como desde el punto de vista de la responsabilidad patrimonial sanitaria. La inteligencia artificial se rige por los principios de legalidad, ética, transparencia, seguridad, no discriminación y protección de datos personales, entre otros. La responsabilidad patrimonial sanitaria se basa en el principio de que la administración debe indemnizar a los pacientes por los daños que sufran como consecuencia del funcionamiento normal y anormal del servicio público de salud.

Así pues, el uso de GPT4 por los pacientes puede generar distintos escenarios de responsabilidad patrimonial sanitaria, dependiendo del grado de intervención humana, del tipo y origen del daño, y del nexo causal entre el uso de GPT4 y el daño. Por ejemplo, si un paciente usa GPT4 para obtener un diagnóstico y este resulta ser erróneo o incompleto, ¿quién sería el responsable? ¿El paciente, por no consultar a un médico? ¿El médico, por no supervisar el uso de GPT4? ¿El desarrollador o proveedor de GPT4, por no garantizar la calidad o fiabilidad del sistema? ¿La administración sanitaria, por no regular o controlar el uso de GPT4?

Estas son algunas de las cuestiones que plantea el uso de GPT4 por los pacientes en relación con la responsabilidad patrimonial sanitaria de la administración. Se trata de un tema complejo y novedoso que requiere un análisis jurídico detallado y una adaptación normativa adecuada a las características y desafíos de la inteligencia artificial aplicada al ámbito sanitario.