El pasado viernes 9 de junio de 2023, durante la sesión especial del Máster de SEDISA-UE, Nacho Medrano argumentó que los LLM no son capaces de responder a preguntas de manera contraria a los hechos con los que entrenaron. Es decir, tienen limitaciones para contraargumentar y crear visiones alternativas.

No puedo negar que, instintivamente, estuve de acuerdo y en desacuerdo simultáneamente.

Si le formulas a ChatGPT el siguiente prompt «¿Pueden los LLMs responder contrafactualmente?«, su respuesta es:

Los Language Models (Modelos de Lenguaje) de gran escala, como GPT-3 y GPT-4, tienen la capacidad de generar respuestas basadas en la información que han aprendido durante su entrenamiento. Sin embargo, no están diseñados específicamente para responder de manera contraria a los hechos o generar respuestas contrafácticas.

Un LLM generalmente se entrena utilizando una gran cantidad de datos del mundo real, y su objetivo principal es generar respuestas coherentes y contextualmente relevantes. No tienen la capacidad de razonar sobre eventos o situaciones hipotéticas que no están respaldadas por datos reales. Esto significa que no pueden generar respuestas contrafácticas en el sentido de proporcionar información sobre cómo podrían haber sido las cosas si los hechos fueran diferentes.

Es importante tener en cuenta que los LLMs están limitados a la información con la que fueron entrenados y no tienen conciencia de eventos futuros o hechos hipotéticos que no se encuentren en sus datos de entrenamiento. Si se les hace una pregunta contrafactual o se les solicita que generen respuestas en ese sentido, es posible que proporcionen respuestas que estén basadas en la información disponible en sus datos de entrenamiento y que sean consistentes con su conocimiento previo, pero no necesariamente reflejarán una realidad alternativa.

Si le preguntas a GPT4 la misma pregunta, la respuesta es:

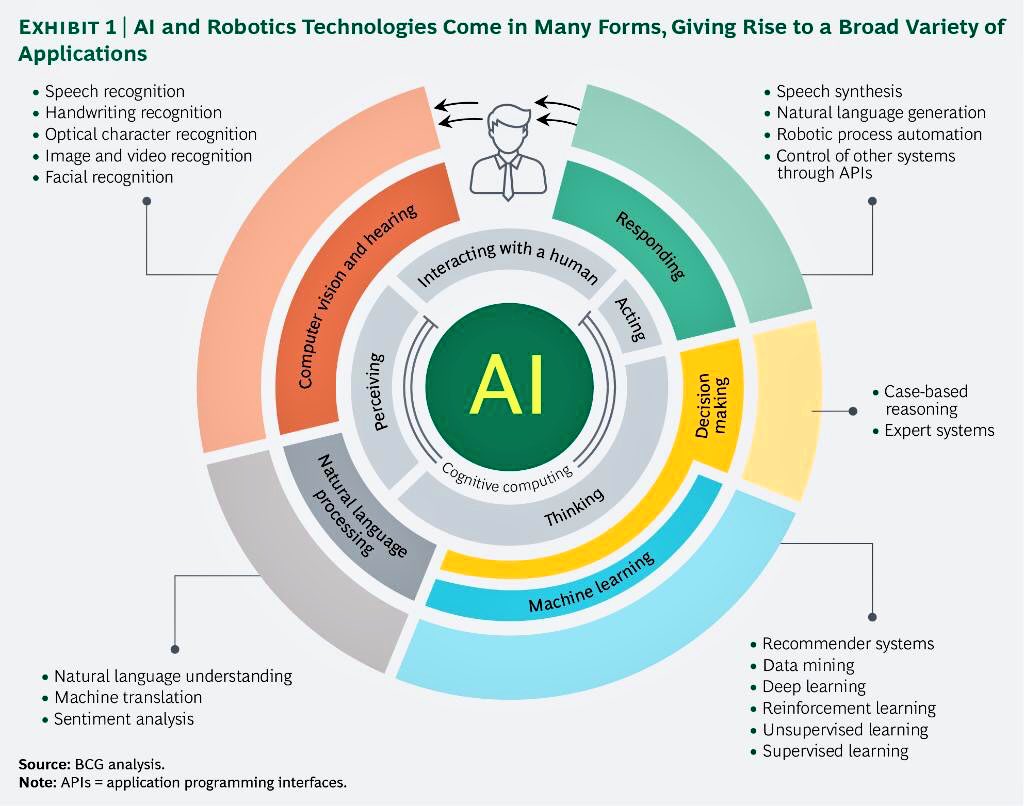

Los LLMs (modelos de lenguaje de aprendizaje profundo) son sistemas informáticos capaces de generar y comprender textos en diferentes idiomas y dominios. Estos sistemas se basan en redes neuronales artificiales que aprenden de grandes cantidades de datos textuales, como libros, artículos, noticias, etc. Una de las aplicaciones más interesantes de los LLMs es la generación de textos creativos, como poemas, cuentos, canciones o ensayos.

Sin embargo, ¿cuán creativos son realmente los LLMs? ¿Pueden generar textos que no se basen solo en lo que han visto en los datos, sino también en lo que podría haber sido o lo que podría ser? Es decir, ¿pueden responder contrafactualmente?

El razonamiento contrafactual es la capacidad de imaginar escenarios alternativos a la realidad, modificando algunos aspectos o condiciones de lo que ocurrió o podría ocurrir. Por ejemplo, si yo digo «Si hubiera estudiado más, habría aprobado el examen», estoy haciendo una afirmación contrafactual, ya que estoy cambiando un hecho del pasado (mi nivel de estudio) y sus consecuencias (mi resultado en el examen).

El razonamiento contrafactual es importante para el aprendizaje, la toma de decisiones, la resolución de problemas y la creatividad humana. Además, se ha demostrado que los humanos usan el razonamiento contrafactual de forma natural y espontánea cuando se enfrentan a situaciones hipotéticas o imaginarias.

¿Pero qué pasa con los LLMs? ¿Pueden generar textos que contengan afirmaciones contrafactuales? ¿Pueden modificar algunos aspectos de la realidad y explorar sus implicaciones? ¿Pueden crear mundos posibles o alternativos a partir de un texto dado?

La respuesta corta es: sí, pero con limitaciones. Los LLMs pueden generar textos contrafactuales si se les proporciona un contexto adecuado y una instrucción clara. Por ejemplo, si le damos a un LLM un texto sobre un hecho histórico y le pedimos que lo reescriba cambiando algún detalle, es posible que el LLM pueda producir un texto coherente y plausible que refleje ese cambio.

Sin embargo, los LLMs no pueden generar textos contrafactuales de forma autónoma o espontánea. Es decir, no pueden decidir por sí mismos qué aspectos de la realidad modificar o cómo hacerlo. Tampoco pueden evaluar la verosimilitud o la relevancia de sus afirmaciones contrafactuales. Los LLMs dependen en gran medida del contexto y la instrucción que se les da, y no tienen una comprensión profunda del significado o las implicaciones de sus textos.

Por lo tanto, podemos decir que los LLMs pueden responder contrafactualmente, pero solo de forma superficial y limitada. No pueden generar textos contrafactuales originales o creativos que vayan más allá de lo que han visto en los datos. Para lograr eso, se necesitaría dotar a los LLMs de una capacidad de razonamiento causal y una representación semántica más rica y flexible.